728x90

ResNet

잔류 학습 Residual Learning 개념을 사용하여 성능 저하를 피하면서 층 수를 대폭 늘린 구조이다.

CNN에서 가중치 학습이 제대로 안되어 있다.

이런 부분들을 나눠서 학습시키는 것이 잔류학습이다.

잔류학습은 지름길 연결된 x를 더한 F(X) + X에 감마를 적용한다.

감마*(F(X) + X)

지름길 연결을 하는 이유

- 깊은 신경망도 최적화가 가능

단순한 학습의 관점 변화를 통해 신경망의 구조를 변화

단순 구조의 변경으로 매개변수 수에 영향이 없다.

덧셈연산만 증가하므로 전체 연산량 증가도 미비하다

- 깊어진 신경망으로 인해 정화도 개선이 가능함

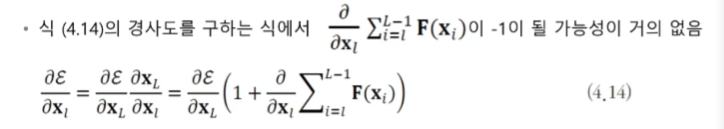

- 경사소멸 문제 해결

가장 많이 쓰이는 모델이다.

728x90

'인공지능 AI > CNN' 카테고리의 다른 글

| CNN GoogLeNet (0) | 2022.02.14 |

|---|---|

| CNN VGGNet (0) | 2022.02.14 |

| CNN AlexNet (0) | 2022.02.14 |

| CNN AlexNet tensorFlow 실습 (0) | 2022.02.09 |

| CNN AlexNet Pytorch 실습 (0) | 2022.02.09 |