728x90

이전에 올렸던 Mnist MLP에서 정확도를 높일 수 있는 방법이 무엇인지 알아본다.

우선 optimizer의 경사하강법 함수의 보폭을 r = 0.1 에서 r = 0.01 로 변경해보았다.

정확도가 상승한 것을 확인할 수 있다.

테스트 정확도도 92% 손실값 0.265613 으로 향상된 것을 볼 수 있다.

r을 더 줄여서 r = 0.001로 변경해보니

정확도에 큰 차이가 없었다.

속도를 위해 r = 0.01인 것이 낫다는 생각이 들었다.

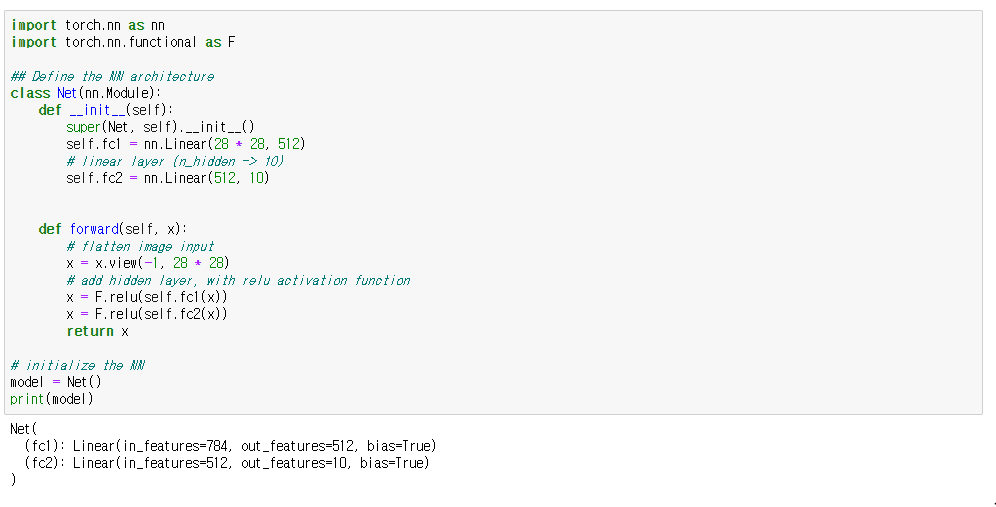

다시 전체 코드를 원 상태로 만들고, 이번에는 Net class의 ReLU 함수를 두개의 레이어에 대해 적용했다.

원래는 self.fc1에 대한 ReLU 만 작성 되어 있었다.

트레이닝 셋에서 손실값이 0.017782 값으로 눈에 띄게 줄어들었다.

테스트에서는 97%의 정확도와 손실값 0.0066920값으로 매우 향상된 것을 확인할 수 있다.

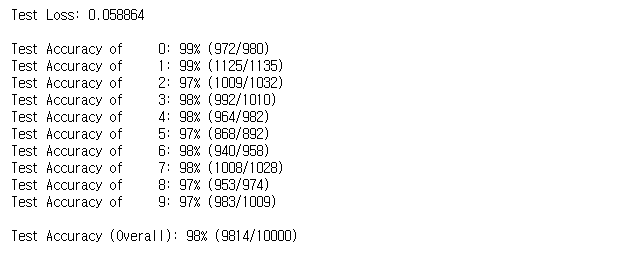

위에서 확인한 두가지를 동시에 적용한다면

98%로 거의 100%에 도달하는 모습이다.

728x90

'인공지능 AI > MLP' 카테고리의 다른 글

| MLP MNIST 숫자 분류 pytorch에서 Tensorflow로 변환 (0) | 2022.02.12 |

|---|---|

| Mnist MLP Pytorch 숫자 인식 (0) | 2022.02.11 |

| MLP 인공신경망 오류역전파 autograd pytorch iris 데이터 분류 SGD (0) | 2022.02.09 |

| Pytorch Autograd MLP 자동미분연산 경사하강법 오류역전파 (0) | 2022.02.08 |

| MLP 다층 퍼셉트론 오류역전파 알고리즘 미니배치 경사하강법 (0) | 2022.02.08 |